La gravità, i quanti ed i bordi.

Provocazione: noi non siamo altro che ologrammi di uno spazio-tempo granulare.

Premessa doverosa: queste considerazioni sono derivate essenzialmente da quattro assunzioni.

- 0. Ologrammi

- 1. Teoria della gravitazione quantistica a loop (granularità dello spaziotempo)

- 2. Principio di indeterminazione di Heisemberg

- 3. Entropia dei buchi neri (entropia di Bekenstein-Hawking)

Qua sotto descrivo succintamente le basi del mio (s!)ragionamento.

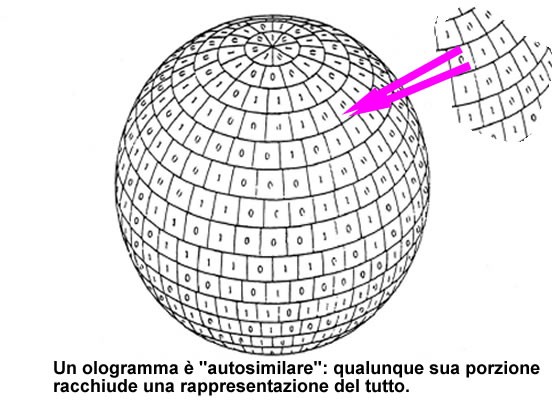

0. Gli ologrammi.

Ricordate la principessa Leila che comunica con Obi e Luke in guerre stellari? Era un ologramma.

Ricordate la principessa Leila che comunica con Obi e Luke in guerre stellari? Era un ologramma.

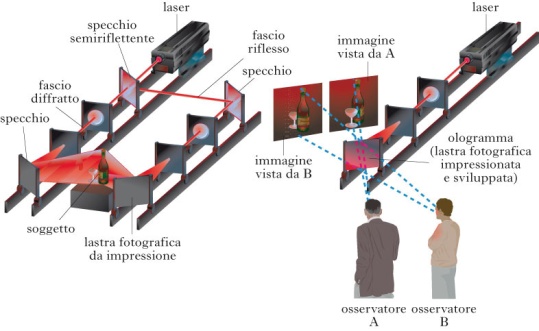

E’ un’immagine tridimensionale di un oggetto su lastra fotografica ottenuta sfruttando l'interferenza di due fasci di luce laser, uno diffratto dall'oggetto e l'altro riflesso da uno specchio.

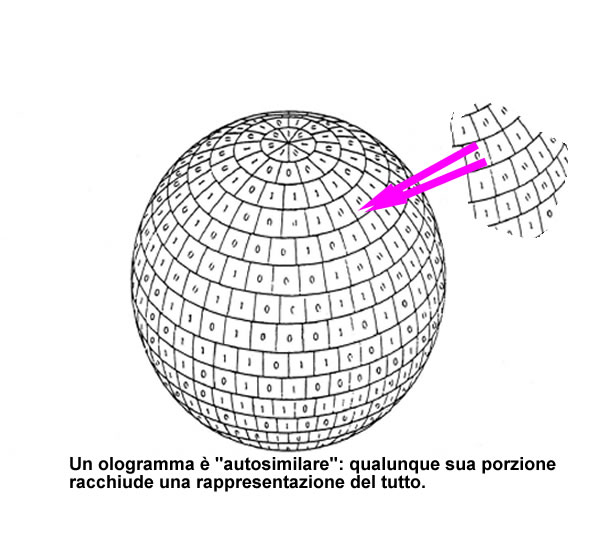

Ogni parte dell'ologramma, contiene l'intera informazione: tagliando in due parti l'ologramma entrambe mostreranno sempre l'oggetto per intero.In parole semplici posso rappresentare un oggetto tridimensionale con un oggetto(la lastra) a due dimensioni, una in meno.

- Teoria della gravitazione quantistica a loop

La gravità quantistica a loop (LQG, dal termine inglese loop quantum gravity), conosciuta anche coi termini di gravità a loop, geometria quantistica e relatività generale canonica quantistica, è una teoria fisica di gravità quantistica, ovvero una teoria quantistica dello spazio-tempo che cerca di unificare la meccanica quantistica e la relatività generale. Rimandando ad approfondimenti specifici presenti sul web, qui possiamo dire che tale teoria cerca con successo di rendere quantizzato lo spazio tempo, mantenendo sia le caratteristiche della meccanica quantistica (indeterminazione, discretezza) che quelle della relatività generale (covarianza, indipendenza dal background). Rovelli e Smolin sono tra I pionieri di tale teoria, che personalmente reputo più completa di altre (teoria delle stringhe), che necessitano di un background indipendente per funzionare.

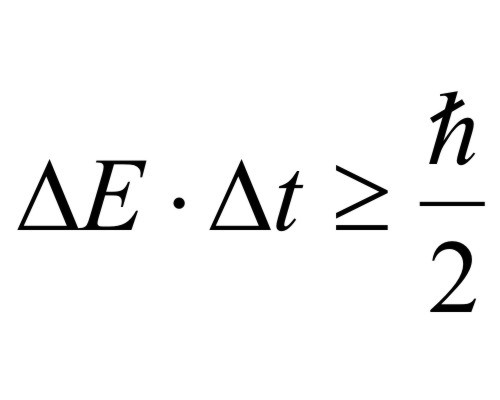

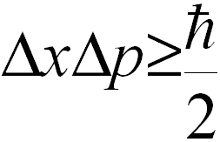

2. Principio di indeterminazione di Heisemberg

Stabilisce un limite alla precisione delle misure che possiamo fare su un sistema microscopico. Gli errori che possiamo fare circa la posizione e la quantità di moto sono inversamente proporzionali, cioè più piccolo è uno, più grande è l’altro. Inoltre, l’energia di un sistema è grosso modo dipendente dalla durata della misura.

Questo principio discende dal fatto che lo spazio delle fasi di un sistema fisico microscopico non è continuo ma ha un limite minimo dato dal “quanto d’azione” di Planck. Le coordinate dello spazio delle fasi sono proprio x e p e il rettangolo minimo è proprio la larghezza di x e p .

Ps.: dovrei dire cosa è lo spazio delle fasi. Qua accenno solo al fatto che è un diagramma in cui non metto il tempo sulle ascisse e la variabile misurata sulle ordinate (ad es. La posizione), ma metto sugli assi tutte le variabili che caratterizzano completamente uno stato fisico. Un’area chiusa di questo spazio si chiama azione, ed il rettangolino che vedete in grigio è, appunto, il quanto di minima azione, h. Si capirà che in tale spazio, tassellato di rettangoli minimi, le traiettorie con sono più nè continue nè definite. Salta in aria quasi tutta la matematica classica, basata su uno spazio continuo.

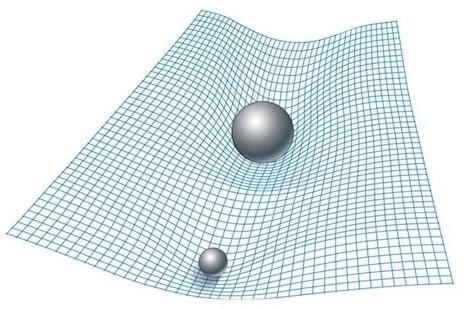

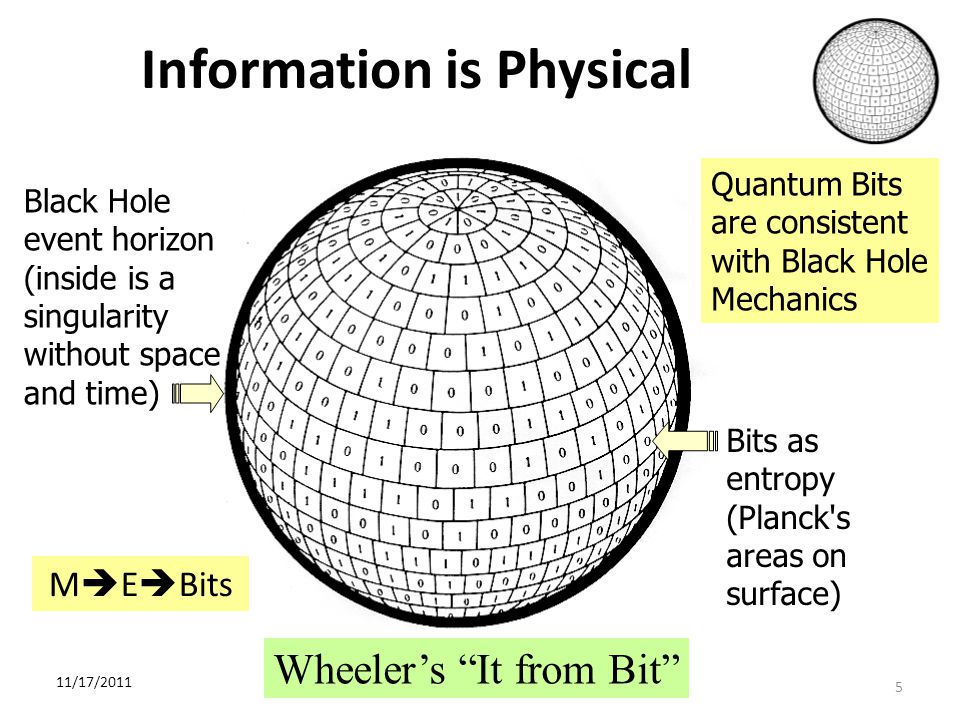

- Entropia dei buchi neri (entropia di Bekenstein-Hawking)

L’entropia di un buco nero è proporzionale all’area A dell’orizzonte degli eventi che lo circonda, per esser precisi è proporzionale ad un quarto di tale area. Sono presenti come costanti di proporzionalità la costante kb di Bolzmann (legame con la termodinamica) e lp, lunghezza di Planck (legame con la meccanica quantistica). Da notare che questa è anche l'entropia massima che può essere confinata in un volume di spazio che contiene una data quantità di energia ("limite di Bekenstein"). Dà grosso modo l’idea di quanta informazione sia contenuta in qualcosa che è circondata da una superficie, sulla quale è “mappata” tale informazione.

L’entropia di un buco nero è proporzionale all’area A dell’orizzonte degli eventi che lo circonda, per esser precisi è proporzionale ad un quarto di tale area. Sono presenti come costanti di proporzionalità la costante kb di Bolzmann (legame con la termodinamica) e lp, lunghezza di Planck (legame con la meccanica quantistica). Da notare che questa è anche l'entropia massima che può essere confinata in un volume di spazio che contiene una data quantità di energia ("limite di Bekenstein"). Dà grosso modo l’idea di quanta informazione sia contenuta in qualcosa che è circondata da una superficie, sulla quale è “mappata” tale informazione.

Ok, procediamo.

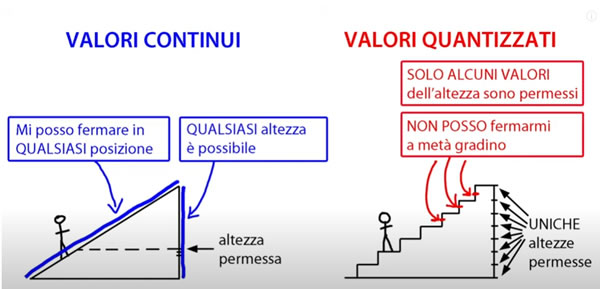

La natura procede a salti ed è fatta di salti. La continuità è solo un comodo espediente per semplificare la spiegazione di ciò che accade. Quando disegniamo qualcosa oppure quando vediamo la tv, se ci avviciniamo possiamo scorgere che quello che abbiamo visto o disegnato è in realtà una sequenza di punti. Tutto è quantizzato,

fatto di parti discrete e non ulteriormente divisibili. E queste parti non possono stare ferme o meglio se ne fermo alcune, altre loro caratteristiche scappano via.

Ci sono quindi dei limiti invalicabili alla conoscenza completa del mondo, non posso conoscere tutto. Inoltre la conoscenza che posso avere dipende fondamentalmente dall'interazione che ho, dalla relazione che ho, con le cose. Senza relazione non posso dire che esistano le cose, nessuno mi autorizza a farlo.

Ulteriore considerazione. Quando descrivo dei fenomeni, di qualunque natura essi siano, noto che sono inseriti in un contesto. Tutta la storia umana, non solo della scienza (pensiamo alla politica!), ha sempre inserito, anche implicitamente, ciò che accade in un sottofondo, come un palcoscenico in cui recitano degli attori. Anche le più recenti conquiste o teorie scientifiche, come la meccanica quantistica o la teoria delle stringhe, tengono conto di un sottofondo, background, dato per scontato ed "esterno" alle teorie. In altre parole, descrivo un fatto supponendo che il contesto sia dato e sostanzialmente immutabile.

La teoria generale della reltività di Einstein, invece, è il tentativo, riuscito , ma cercherò di spegare dopo, quasi riuscito, di strutturare un qualcosa di indipendente dal sottofondo, in cui cioè anche il sottofondo fa parte della rappresentazione, del luogo specifico in cui accadono i fenomeni. Parte integrante ed interagente, non passiva, inerte. E la nuova fisica deve muoversi così: indipendenza dal background (si chiama covarianza) e pure indipendente dal particolare sistema di coordinate che uso (diffeomorfismo). La nuova teoria deve gestire solo le relazioni tra gli elementi interagenti, che generano sia l'evoluzione dei fenomeni che il luogo in cui si svolgono. Le relazioni generano l'esistenza stessa delle cose.

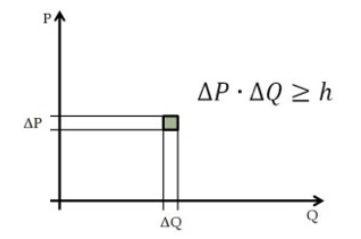

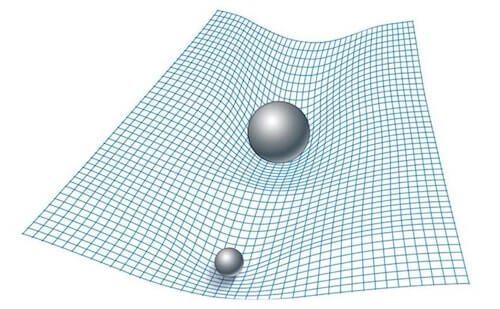

Come accennavo, la teoria della relatività generale spiega molto bene i fenomeni gravitazionali su media e larga scala. E lo fa ipotizzando che la forza di gravità è un effetto della curvatura geometrica dello spazio-tempo. Le masse curvano tale spazio- tempo e la curvatura determina le traiettorie delle masse stesse, in un continuo ed incessante balletto. Tale teoria però presuppone che lo spazio-tempo sia continuo e tale caratteristica porta alla perdita di significato della teoria stessa quando tratta di masse molto grandi concentrate in uno spazio molto piccolo (buchi neri). Le grandezze in gioco, come le masse ed i volumi, divergono: o infinite o infinitamente piccole. Affiorano inoltre dei paradossi, come la perdita totale delle informazioni che cadono dentro un buco nero, cosa reputata impossibile. Tentare di risolvere tali limiti è lo sforzo di tutto un settore della fisica che si occupa di fondere la relatività generale con l'altra teoria della natura, la meccanica quantistica, che ha un approccio con gli infiniti meno traumatico. E come si cerca di farlo?

Anche lo spazio ed il tempo sono quantizzati, granulari. Lo spazio cioè è suddivisibile fino ad un certo punto, che si chiama lunghezza di Plank, pari a qualcosa come 1,6 10-35 metri. E' un valore molto piccolo. Se un protone fosse grande come il sole, tale distanza sarebbe meno di un millimetro, ma è pur sempre diversa da 0. La meccanica quantistica impone tale limite: se ci fosse un valore minore tutto l'universo, tutte le particelle in esso contenute, collasserebbero in un buco nero.

Se un protone fosse grande come il sole, tale distanza sarebbe meno di un millimetro, ma è pur sempre diversa da 0. La meccanica quantistica impone tale limite: se ci fosse un valore minore tutto l'universo, tutte le particelle in esso contenute, collasserebbero in un buco nero.

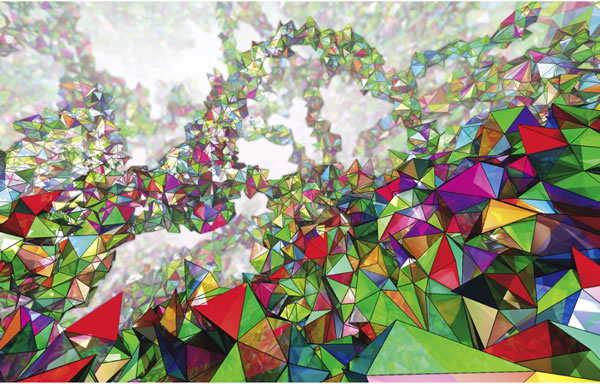

La lunghezza di Plank determina la superfice ed il volume di Plank basta farne il quadrato o il cubo). Lo spazio-tempo è cioè una sorta di reticolo, di "cubetti" piccolissimi che riempiono tutto l'universo ed in cui sono collocate e si muovono tutte le masse. Tale reticolo, a sua volta, sempre per le leggi della meccanica quantistica (principio di indeterminazione di Heisemberg), non può stare fermo ma si agita, si deforma, è più simile alla schiuma da barba che ad una rete. Al vertici di tale reticolo sono collocati gli atomi di spazio. I fisici lo chiamano "schiuma di spin". Nella figura all’inizio è rappresentata una simulazione di tale "spin foam". La parola spin sottintende che sono strutture orientate e quindi capaci potenzialmente di possedere una qualche informazione, cosa che ci potrà tornare utile in seguito.

Questa impossibilità di star fermi e quindi di stare sempre in interaziore reciproca, deformandosi, allargandosi, stirandosi dipende dal fatto che anche gli atomi di spazio obbediscono, appunto, al principio di indeterminazione di Heisemberg, uno dei pilastri della meccanica quantistica. Tale principio stabilisce, oltre alla impossibilità di avere misure precise contamporanee della posizione e della velocità (per essere più precisi, quantità di moto) delle particelle, anche l'impossibilità di misurarne la loro energia con precisione. Sono fatti acclarati, strani e non intuitivi, ma senza di esso non funzionerebbero i cellulari. Questa indeterminazione dell'energia, in questo caso degli atomi di spazio, come vedremo, ha ripercussioni fondamentali nell'evoluzione di tutto l'universo. Facciamo prima una premessa terminologica; la differenza tra vuoto e niente. Il vuoto è lo spazio senza materia. Il niente è ciò che sta tra gli atomi di spazio. Le interazioni fondamentali della natura, forte, debole ed elettromagnetica si hanno anche nel vuoto, mentre gli atomi di spazio non hanno bisogno di nulla per interagire. Lo spazio è granulare. Strano, no?

Detto questo, l'indeterminazione sull'energia dei quanti di spazio può determinare che lo spazio possa acquistare un'energia diversa da 0 ed anche esercitare una pressione. Da qui può derivare una caratteristica misurata dello spazio vuoto: la costante cosmologica, una pressione espansiva molto bassa ma capace di spingere l'universo ad espandersi in modo accellerato. La storia della costante cosmologica è una corsa ad ostacoli, via via superati. La quantizzazione dello spazio cioè può essere la spiegazione della sua pressione intrinseca, non gli effetti quantomeccanici della materia, che porterebbero a previsioni assurde sul valore della costante cosmologica Λ. Se volete approfondire cosa sia il vuoto fisico e che proprietà possiede potete dare uno sguardo a questo video cosa è i l vuoto quantistico . Attenzione, però! Anche se appare tutto strano ed esoterico, dobbiamo tener presente che le caratteristiche del vuoto attuali sono comunque un fatto standard e consolidato. Qui si cerca di fare uno step in più, piuttosto temerario. vediamo come.

A questo punto possiamo fare un'ipotesi sulla gravità. Quante volte abbiamo visto un'immagine del genere? Masse che distorcono la struttura geometrica dello spazio-tempo come palle su una rete elastica? ma cosa è questa rete? Possiamo dare una possibile risposta: è il reticolo degli atomi di spazio che viene distrurbato dalla presenza della materia. Lo spazio si deforma e quindi le traiettorie di tutti gli oggetti si deformano, compreso la luce che lo attraversa. Le traiettorie naturali degli oggetti seguono le deformazioni del reticolo e si incurvano; ecco l'affioramento della gravità.

A questo punto possiamo fare un'ipotesi sulla gravità. Quante volte abbiamo visto un'immagine del genere? Masse che distorcono la struttura geometrica dello spazio-tempo come palle su una rete elastica? ma cosa è questa rete? Possiamo dare una possibile risposta: è il reticolo degli atomi di spazio che viene distrurbato dalla presenza della materia. Lo spazio si deforma e quindi le traiettorie di tutti gli oggetti si deformano, compreso la luce che lo attraversa. Le traiettorie naturali degli oggetti seguono le deformazioni del reticolo e si incurvano; ecco l'affioramento della gravità.

Bordi.

Fino a questo punto abbiamo trattato lo spazio e la materia in esso contenuta in modo diverso: sono pur sempre entità distinte anche se la teoria quantistica della gravità è indipendente dal background. Essa va intesa sempre nel senso che "la materia incurva lo spazio-tempo e la curavatura dice alla materia come muoversi". Ma qui entrano in gioco Archibald Wheeler, Steven Hawking e Bekenstein.

I loro lavori sulla entropia dei buchi neri (il fatto che tale entropia sia proporzionale alla superficie dell'orizzonte degli eventi) possono gettare una luce nuova, direi rivoluzionaria, su come può essere fatto ciò che esiste ad una scala più profonda. L'entropia dell'universo si può pensare "mappata" sul suo bordo ( si veda pure un mio precedente articolo ( h ttps://www.giamod.it/nuova/index.php/84-fisica-e-dintorni/163-bit-dell-universo ) che dà il via al concetto di universo olografico, tramite il quale possiamo concepire il nostro modo descritto completamente dai bits (qbits) immagazzinati nel bordo che lo circonda. Ma osserviamo che non è necessario pensare ad un bordo universale tassellato di celle della dimensione di aree di Plank: ogni bordo che circonda qualunque cosa presente nel nostro universo contiene le informazioni necessarie e sufficienti per descrivere cosa c'è dentro di esso. Ed allora: se la schiuma di spin nel suo eterno cambiare forma per gli effetti quantistici che la governano di "corrugasse" in una  forma chiusa, in un bordo, appunto, cosa accadrebbe?

forma chiusa, in un bordo, appunto, cosa accadrebbe?

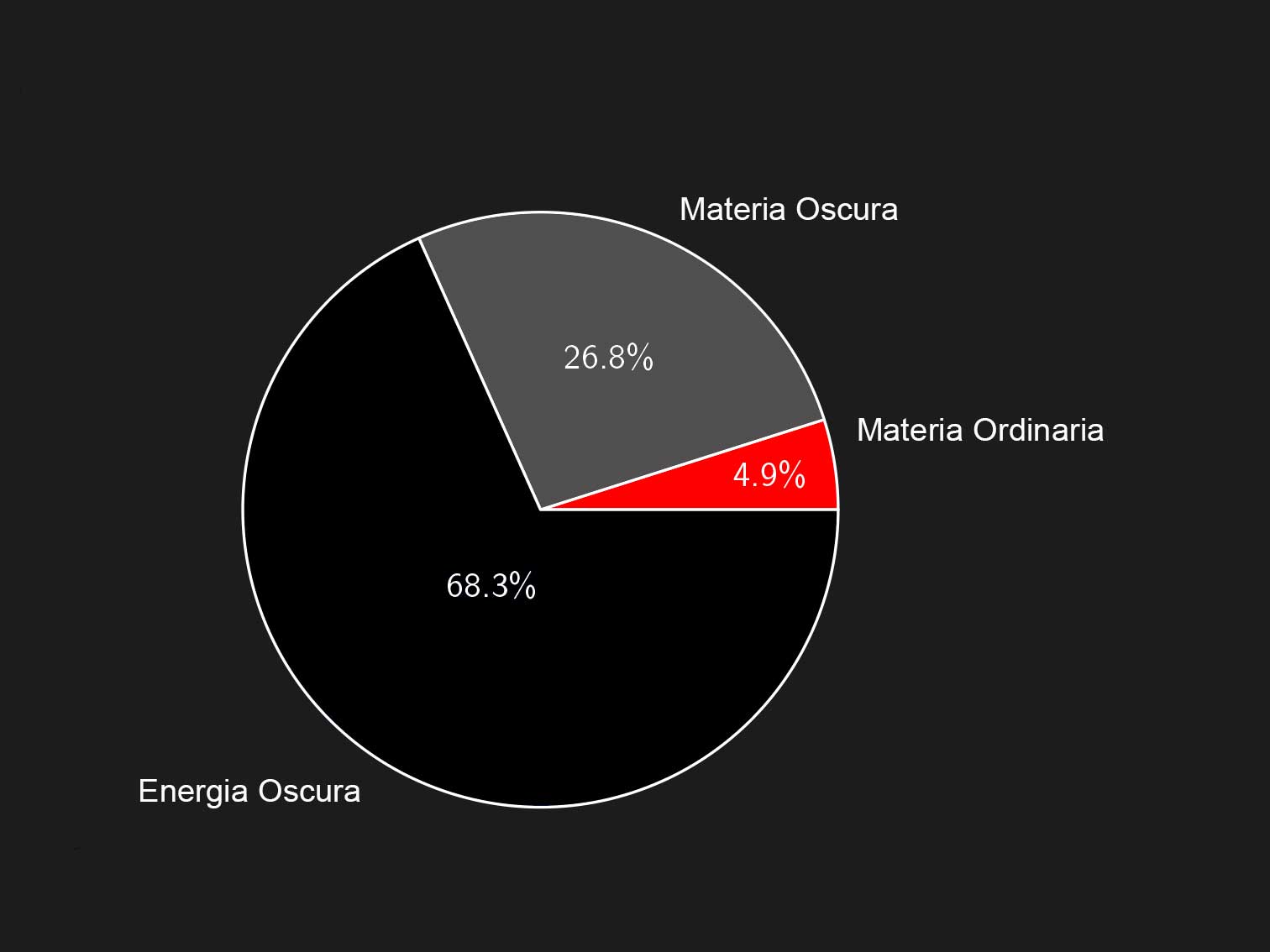

Si creerebbe una massa! Le masse non sono altro che bordi di una struttura granulare chiusa dello spazio tempo. La massa non è più qualcosa di esterno allo spazio, ma è lo spazio stesso non piatto ma chiuso in bolle . Tali bolle possono avere energia e/o struttura sufficiente per essere stabili ed allora generano materia sufficientemente stabile (protoni, elettroni, neutroni , quarks) oppure rompersi generando materia instabile (material oscura?). Un bordo può racchiudere uno o altri bordi, creando strutture via via più grandi.

L'informazione diviene sempre più ricca e complessa arrivando a rappresentare qualunque cosa presente nell'universo, come una immensa matrioska fatta di pura informazione, capace anche di fare questo: osservare se stessa e studiarla (cioè, noi).

In più, se osserviamo la figura a lato, ed applicando una delle proprietà degli ologrammi, il fatto cioè che qualunque sua porzione contenga le informazioni di tutto l'ologramma, possiamo in qualche modo dedurre che cose anche molto lontane nel mondo tridimensionale siano in realtà vicinissime sul bordo, separate cioè da pochissimi atomi di spazio. Sulla superficie cioè scompare la distanza macroscopica. Ecco spiegata la non località della meccanica quantistica: oggetti apparentemente lontanissimi in realtà possono esere vicinissimi. ecco spiegato l'entanglement.

Cioè, in altre parole, tutto l'universo non è altro che l'emergere di pura e semplice informazione.

Naturalmente i problemi aperti sono molteplici: 1) quali sono le forme più probabili che portano alla creazione della materia barionica( quarks, elettroni) e 2) come sono scritti i bits sui bordi?

Come è strano il mondo. Non ha niente a che vedere con ciò che appare. Omaggio a Rovelli.

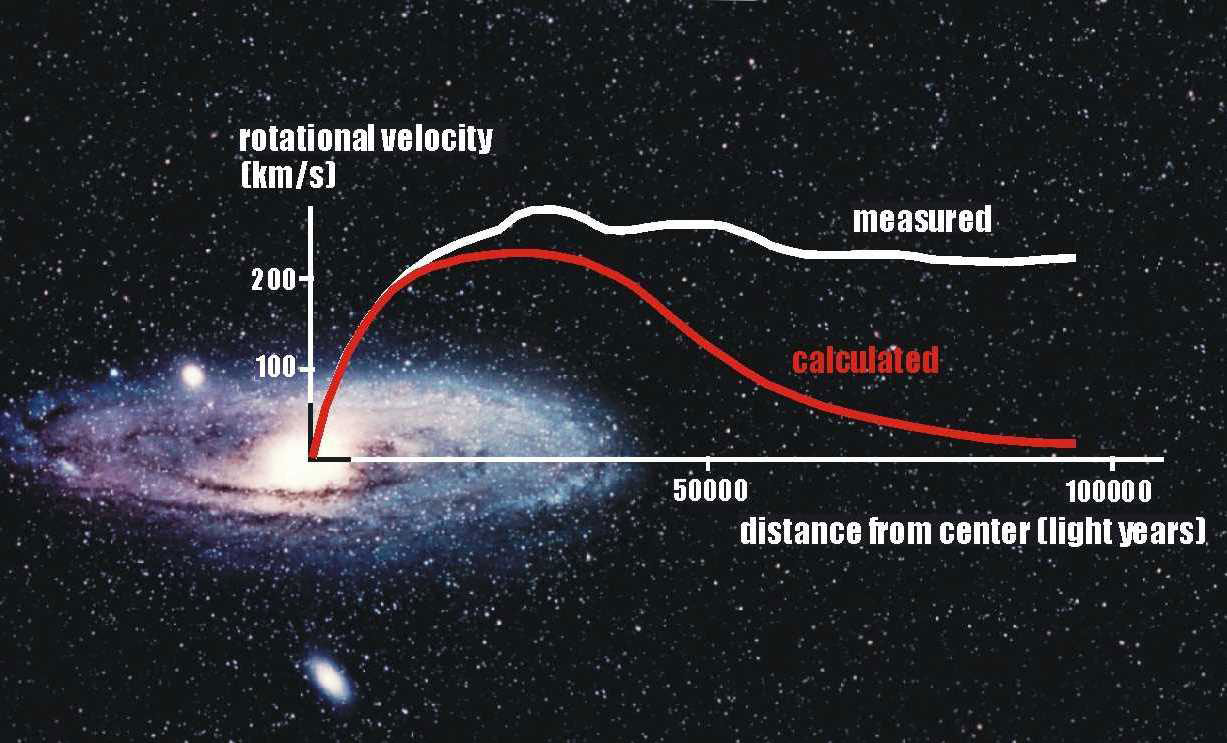

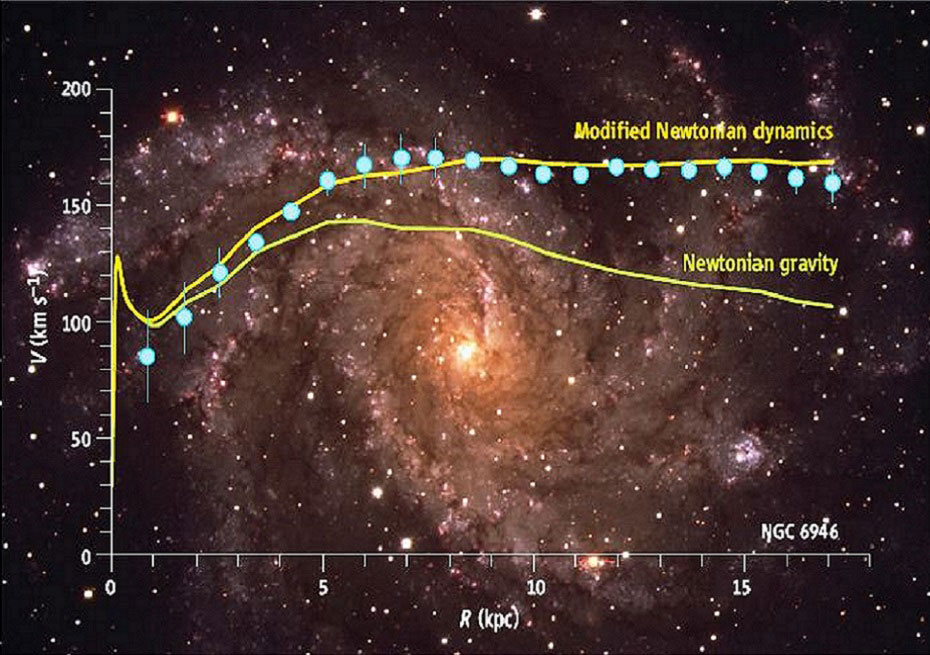

Fig. 1 – Curva di rotazione di una tipica galassia a spirale. La curva rossa è la predizione della legge di gravità Newtoniana; quella bianca rappresenta l’andamento delle misure sperimentali

Fig. 1 – Curva di rotazione di una tipica galassia a spirale. La curva rossa è la predizione della legge di gravità Newtoniana; quella bianca rappresenta l’andamento delle misure sperimentali

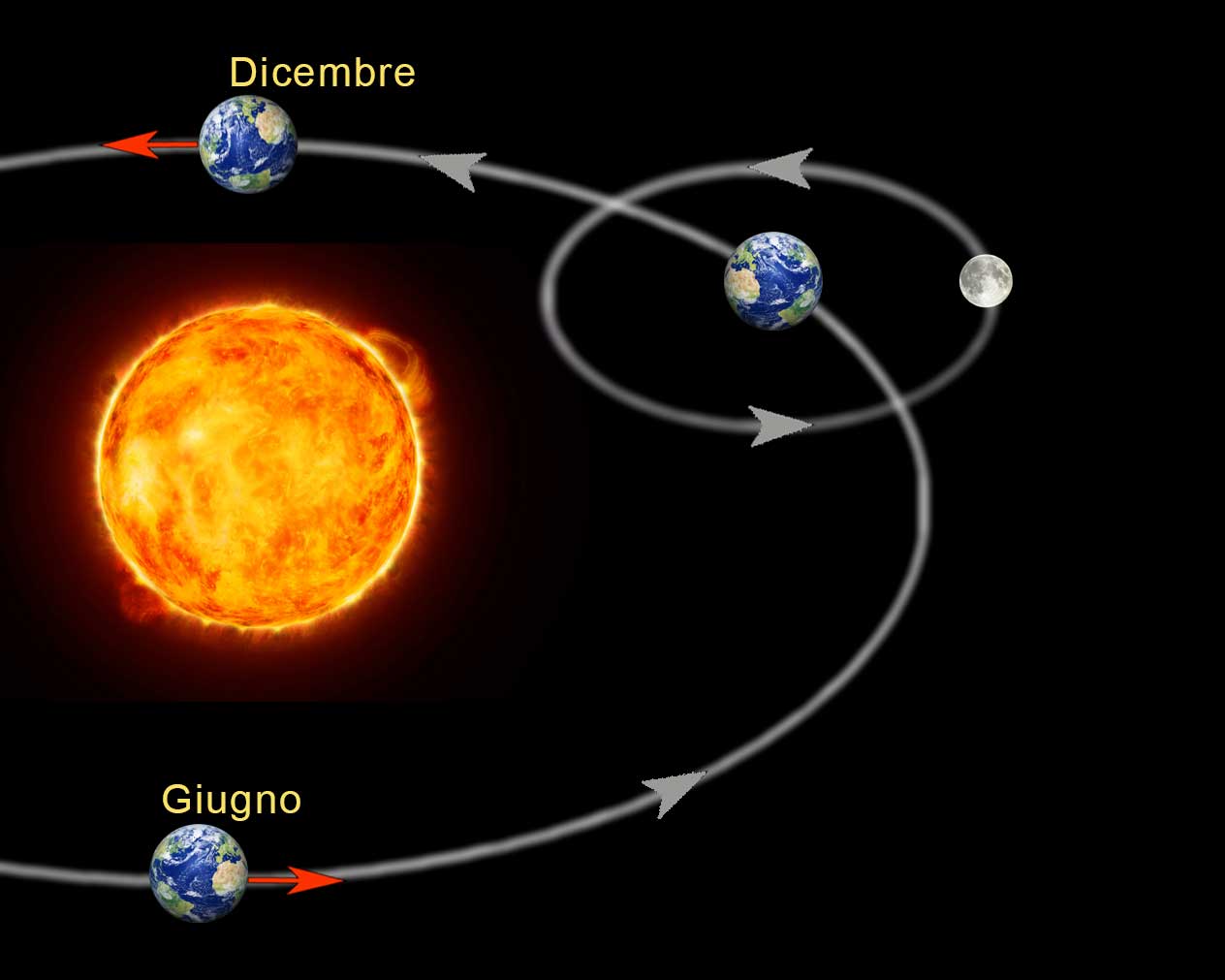

Fig. 3 – Rappresentazione del moto della Terra all’origine del fenomeno della modulazione annuale nel flusso di particelle di materia oscura.

Fig. 3 – Rappresentazione del moto della Terra all’origine del fenomeno della modulazione annuale nel flusso di particelle di materia oscura. Fig. 4 – Curva di rotazione della galassia NGC 6946: confronto delle predizioni della dinamica Newtoniana e di MOND con le osservazioni.

Fig. 4 – Curva di rotazione della galassia NGC 6946: confronto delle predizioni della dinamica Newtoniana e di MOND con le osservazioni.

I loro lavori sulla entropia dei buchi neri (il fatto che tale entropia sia proporzionale alla superficie dell'orizzonte degli eventi) possono gettare una luce nuova, direi rivoluzionaria, su come può essere fatto ciò che esiste ad una scala più profonda. L'entropia dell'universo si può pensare "mappata" sul suo bordo ( si veda pure un mio precedente articolo (

I loro lavori sulla entropia dei buchi neri (il fatto che tale entropia sia proporzionale alla superficie dell'orizzonte degli eventi) possono gettare una luce nuova, direi rivoluzionaria, su come può essere fatto ciò che esiste ad una scala più profonda. L'entropia dell'universo si può pensare "mappata" sul suo bordo ( si veda pure un mio precedente articolo (